L’association MO5.com, dont je suis membre, a pour objet d’assurer la préservation du patrimoine informatique. Dans le cadre de cette activité, nous documentons également l’histoire de l’informatique. Dans cette histoire, on entend régulièrement parler du contrat que Microsoft a négocié avec IBM au tout début des années 1980, qui lui aurait permis de devenir le géant qu’il est aujourd’hui, aux dépens de son ancien partenaire.

Or donc, d’expliquer que Bill Gates, en bon joueur de poker et fin négociateur, a réussi à négocier le contrat du siècle, celui qui permettra à Microsoft de devenir la référence du monde des ordinateurs personnels au détriment d’IBM. Cela fait partie de sa légende, laquelle, il semble bien, ne le dérange pas.

Cependant, si l’on consulte les documents d’époque, les éléments dont on dispose racontent une histoire très différente. Ces documents dressent bien plutôt le portrait d’une série de concours de circonstances que d’une négociation habile d’un jeune dirigeant d’une startup aux abois… Laissez-moi vous raconter comment Microsoft n’a pas négocié ce qui deviendra le contrat du siècle.

Pour reconstituer cette histoire, je me suis basé sur le livre Accidental empires1Cringley, Robert X. (1996). Accidental empires: How the boys of Silicon Valley make their million, battle foreign competition, and still can’t get a date, édition mise à jour, HarperCollins. Disponible sur le site de l’auteur., le documentaire associé Triumph of the Nerds2Cringley, Robert X. (1996). Triumph of the Nerds, Channel 4. Disponible en ligne en deux parties. Il y a également un site compagnon du reportage, qui fleure bon les années 1990 !, l’épisode de Computer Chronicles dédié à Gary Kildall et à Digital Research3Cheifet, Stewart (1995). « Gary Kildall Special », Computer Chronicles, PBS. L’épisode est disponible en ligne., la série d’articles dédiés à ces évènements sur The Digital Antiquarian4Maher, Jimmy (2012). The IBM PC, 4 parties, The Digital Antiquarian. Article publié en ligne., ainsi que le travail de préservation réalisé par l’association MO5.com. Il a fallu recouper les informations, car il s’agit avant tout d’évènements rapportés certes par ses acteurs, mais dont la mémoire est imparfaite et qui peuvent avoir intérêt à ce que l’histoire racontée ne soit pas exactement celle de la réalité des faits. Au demeurant, les éléments sont suffisants pour reconstruire l’histoire la plus probable.

Cet article est publié simultanément sur le site de l’association MO5.com.

Au commencement était IBM

L’ordinateur, dans son acception moderne, est apparu suite à la Seconde Guerre mondiale, qui avait conduit à ce que les prémisses de l’informatique soient utilisées dans l’effort de guerre. Sur ce marché des ordinateurs, alors des machines qui occupaient toute une pièce et que l’on appellera bientôt « mainframe », IBM s’est bientôt imposé comme un acteur incontournable. Ses décisions orientaient le marché. Toutefois, une autre forme d’ordinateurs, les miniordinateurs, est apparue, qui offraient certes un peu moins de puissance de calcul, mais qui avaient l’avantage de n’occuper qu’une place équivalente à quelques armoires plutôt qu’une pièce entière. Dans ce domaine, d’autres constructeurs qu’IBM sont parvenus à se faire connaître au côté du géant. Citons par exemple la série des PDP du constructeur DEC, très utilisés dans le milieu universitaire.

En 1971, Intel va commercialiser une nouveauté qui va permettre une nouvelle évolution dans l’informatique : le microprocesseur. Un processeur est une unité de traitement logique des données : c’est l’entité qui regroupe les capacités de calcul et de traitement des données de l’ordinateur. À l’origine, le processeur était composé de plusieurs éléments matériels indépendants qui communiquaient entre eux. Le principe du microprocesseur consiste à rassembler les différents éléments constitutifs d’un processeur dans un composant unique, ce qui permet de gagner énormément de place, mais également de grandement améliorer l’usage énergétique, ainsi que la vitesse de communication entre les différentes unités du processeur.

L’introduction de ce type de puce va donc permettre de concevoir des ordinateurs beaucoup moins imposants, que l’on peut poser sur un bureau : les microordinateurs.

Signalons, en passant, qu’un des tout premiers, si ce n’est le premier, microordinateur, c’est-à-dire un ordinateur basé sur un microprocesseur, a été conçu en France, à savoir le Micral du bureau d’études R2E. L’association MO5.com en restaure d’ailleurs un exemplaire et en documente l’histoire.

L’apparition des microordinateurs va alors permettre de faire émerger deux nouveaux domaines dans l’informatique : les applications dédiées ne nécessitant que de petites infrastructures – par exemple, le Micral restauré par l’association MO5.com a servi à contrôler des centrifugeuses, – ainsi que l’informatique pour les petites structures (telles que les petites entreprises), voire les particuliers. Ceci va augmenter la taille du marché des ordinateurs.

Puis vint Digital Research

Un ordinateur, que ce soit un mainframe, un mini-ordinateur ou un microordinateur, ne se limite pas simplement à son matériel, il lui faut aussi un logiciel tout à fait central : le système d’exploitation. En effet, chaque composant de l’ordinateur est matériellement capable de communiquer avec les autres composants. Cependant, il faut encore déterminer les conventions permettant à ces composants de s’entendre, ainsi que sous quelle forme les données vont être stockées, mais aussi comment les différents programmes vont pouvoir accéder aux ressources de l’ordinateur, tout comme l’utilisateur. Ces tâches sont remplies par le système d’exploitation.

Au milieu des années 1970, Gary Kildall a créé le système d’exploitation CP/M (Control Program for Microcomputer). Ce système était particulièrement bien adapté aux microordinateurs de l’époque, qui disposaient de peu de ressources, de sorte qu’il est très vite devenu la référence dans ce domaine naissant. Afin de pouvoir commercialiser ce système d’exploitation, Gary Kildall va fonder en 1974 Digital Research, un des tout premiers éditeurs de logiciels dédiés aux microordinateurs.

Par ailleurs, le fabricant d’ordinateurs Seattle Computer Products (SCP) commercialisait des kits basés sur les processeurs Intel 8086. Dans un premier temps, SCP fournissait ses kits sans système d’exploitation, mais il est rapidement apparu que les ventes seraient bien meilleures si les kits disposaient d’un système d’exploitation dédié. Toutefois, plutôt que de recourir à CP/M-86 de Digital Research, SCP va confier à l’un de ses employés, Tim Paterson, le soin de réaliser une alternative. Le résultat sera un système d’exploitation proposant la même interface de programmation et quasiment les mêmes commandes que CP/M, dont le nom commercial était 86-DOS (DOS pour Disk Operating System). Gary Kildall a émis des soupçons, mais Tim Paterson a toujours nié s’être inspiré du code lui-même de CP/M : ainsi, selon les dires de ce dernier, il s’agissait d’un système d’exploitation compatible, mais pas d’un clone.

C’est dans ces mêmes années que Microsoft a été fondé (plus précisément en 1975), en se positionnant sur ce marché émergent. L’entreprise vendait principalement des interpréteurs du langage Basic, lesquels avaient acquis une bonne réputation.

L’informatique croque la pomme

Dans les années 1970, deux passionnés d’électronique et plus particulièrement d’informatique, Steve Wozniak et Steve Jobs, vont créer un microordinateur qui soit plus facile d’accès que ceux alors disponibles. Ce sera l’ordinateur Apple-1, pour la commercialisation duquel ils vont créer l’entreprise Apple en 1976. Si ce premier ordinateur était déjà une avancée en termes d’accessibilité, il nécessitait encore pour son acheteur d’être capable de monter les différents composants de l’ordinateur. Un point auquel l’ordinateur d’Apple suivant, l’Apple ][, commercialisé en 1977, va remédier.

Ce nouvel ordinateur était vendu déjà assemblé et avec un système d’exploitation conçu pour pouvoir être utilisé sans passer trop de temps à lire un manuel d’utilisation complexe. Ainsi, il va permettre d’élargir le public intéressé par les microordinateurs. Cet ordinateur possédait également plusieurs ports d’extensions, c’est-à-dire des emplacements dans lesquels on pouvait insérer des cartes électroniques permettant d’élargir les possibilités de l’ordinateur. Ainsi, cet ordinateur pouvait-il s’adapter à un vaste éventail de tâches.

Un logiciel va notamment apparaître qui va entraîner l’adoption du microordinateur dans de nombreuses entreprises, notamment de petites tailles : VisiCalc, le premier logiciel de tableur, paru en 1979. Facilitant la création de bilans comptables, ainsi que les projections financières, ce logiciel va très rapidement connaître un succès important, pour un logiciel de l’époque, auprès des métiers de la finance.

IBM suit la vague

Ainsi, à la toute fin des années 1970, une nouvelle demande était apparue pour des microordinateurs équipés de tableurs. Également, les premiers logiciels de traitement de texte étaient apparus, ce qui permettait de réunir en un seul système les fonctionnalités d’aide aux travaux financiers et à la rédaction de documents usuellement réalisés à l’aide de machines à écrire. Les clients d’IBM étaient plutôt de grands groupes que de petites entreprises, mais ils étaient enclins à équiper leurs employés, au moins ceux des services financiers, de telles machines. Étant déjà clients d’IBM, ils préféraient avoir le même fournisseur tant pour leurs mainframes que pour leurs machines de bureau. Aussi remontèrent-ils une demande auprès d’IBM. De plus, pour IBM, commercialiser des microordinateurs pourrait lui permettre d’élargir sa clientèle.

Cependant, les dirigeants d’IBM ne croyaient pas que la micro-informatique puisse devenir une branche véritablement importante. Pour eux, ce marché resterait toujours relativement limité. Or, les marges potentielles de bénéfices apparaissaient clairement plus faibles que sur les gros systèmes. Ils décidèrent donc bien de lancer la conception d’un microordinateur, mais avec l’objectif de le faire à moindre coût. Par ailleurs, il apparaissait clairement que pour avoir une chance d’entrer dans ce marché, il fallait être capable de concevoir le nouvel ordinateur en peu de temps, ce qui était contraire à l’organisation usuelle d’IBM.

Ceci va avoir un impact important sur la manière de conduire le projet. Tout d’abord, l’équipe qui a travaillé sur l’IBM PC 5150 (PC pour Personal Computer) a disposé de peu de temps, ce qui impliquait qu’une part importante du travail devait être externalisée. En particulier, en dépit de l’expérience d’IBM en la matière, le système d’exploitation ainsi que les compilateurs5Un compilateur est un programme permettant de transformer un code source en programme exécutable par la machine, c’est donc l’outil central et nécessaire à la création de logiciels. ont été réalisés par des éditeurs tiers.

Pour le système d’exploitation, IBM s’est bien entendu tourné vers le leader du marché et a contacté Digital Research pour lui demander de produire une version de CP/M adaptée à l’IBM PC 5150. Au contraire de Microsoft, Digital Research était alors une entreprise prospère. De sorte que la juriste de l’entreprise a été bien plus regardante sur les conditions du contrat. Et ce qu’elle a lu lui apparut comme tout à fait inacceptable : en résumé, Digital Research n’aurait pas le droit de communiquer sur l’IBM PC 5150, encore moins sur ses spécifications. À l’inverse, IBM pouvait réaliser toute la communication qu’il souhaitait et la version de CP/M serait reversée à son actif, lui permettant ensuite de réaliser des développements internes sur ce système d’exploitation. Autrement dit, non seulement Digital Research ne pourrait pas communiquer sur le travail réalisé pour l’IBM PC 5150, c’est-à-dire qu’il ne pourrait pas vraiment valoriser ce travail pour obtenir de nouveaux marchés, mais en plus serait-il dépossédé de ce travail. Si avoir un contrat avec IBM en soit était intéressant, Digital Research n’en avait pas besoin pour assurer sa survie. Il était donc bien plus important pour ses dirigeants de conserver la propriété de leurs travaux. Par ailleurs, il y avait bien peu d’entreprises capables de fournir un système d’exploitation fonctionnel pour cette machine dans les délais impartis – et Microsoft n’en faisait alors pas parti, – de sorte que la position de Digital Research dans la négociation était bien plus forte que ne le pensaient les négociateurs d’IBM. Ainsi, cette négociation a-t-elle patiné6Les dirigeants ne Microsoft ont déclaré, par exemple dans Revenge of the nerds, avoir adressé IBM à Digital Research, mais Gary Kildall aurait été plus intéressé par piloter son avion que de répondre à IBM. Cependant, cette version est démentie par les employés de Digital Research, par exemple dans l’épisode spécial des Computer Chronicles consacré à Gary Kildall, ainsi que par le travail du journaliste Andrew Orlowski, tant dans MS-DOS paternity suit settled (30 juillet 2007, The Register, disponible en ligne) que dans Bill Gates, Harry Evans and the smearing of a computer legend (7 août 2012, The Register, disponible en ligne). Par ailleurs, il est peu crédible que l’équipe de développement de l’IBM PC 5150 ait entendu parler de Microsoft, à l’époque une très petite structure, mais pas de Digital Research, qui était alors un acteur majeur du monde de la microinformatique. La version présentée ici est donc celle qui est la plus probable..

Les dirigeants de Microsoft ont eu vent de ces difficultés de négociations. Bill Gates, PDG de Microsoft, a alors effectivement lancé un coup de bluff. Il savait que SCP disposait d’un système d’exploitation compatible avec CP/M et dédié à l’architecture de processeur sélectionnée par IBM pour le PC 5150. Bill Gates eut l’idée de racheter 86-DOS à SCP et de l’adapter à l’IBM PC 5150. Avant même de lancer des négociations avec SCP, il annonça à IBM qu’il disposait d’un système d’exploitation qu’il pouvait aisément adapter à l’IBM PC 5150. En négociant avec SCP, il obtint pour 25 000 $ une licence non-exclusive sur 86-DOS, le contrat indiquant également que Microsoft paierait 10 000 $ par fabriquant d’ordinateurs qui intégrerait le système d’exploitation, plutôt qu’une part des revenus des copies vendues7Voir la copie du contrat fourni comme élément de preuve dans l’un des procès à l’encontre de Microsoft, disponible en ligne.. De ce point de vue, en effet, Microsoft a réussi une négociation qui lui était tout à fait favorable. Microsoft a de plus recruté Tim Paterson, qui était de toute façon, à l’époque, mécontent de son poste chez SCP. Quant à IBM, s’il est peu probable qu’il était au courant des manigances des dirigeants de Microsoft, il était très heureux de trouver quelqu’un prêt à lui fournir le système d’exploitation dont il avait besoin aux conditions qu’il souhaitait imposer et accepta donc. Microsoft s’engagea ainsi à fournir le système d’exploitation qui sera nommé PC-DOS, aux conditions voulues par IBM. À ce stade, nous sommes encore très loin du contrat du siècle.

Ainsi, IBM a indiqué à Digital Research qu’il n’avait plus besoin de ses services. Cependant, Gary Kildall fini par apprendre que l’IBM PC 5150 serait livré avec un système d’exploitation reproduisant le fonctionnement de CP/M. Mécontent, il engagea des tractations avec IBM, préambule d’éventuelles poursuites judiciaires. Toutefois, il arriva à un arrangement avec IBM : le système d’exploitation ne serait pas lié à la machine, comme c’était alors l’usage. À la place l’acheteur pourrait choisir un système d’exploitation parmi trois possibles : UCSD p-System, CP/M-86 ou PC-DOS. UCSD p-System, dédié à la création et à l’exécution de programme rédigés dans le langage Pascal, était un système d’exploitation de niche, qui n’escomptait pas des ventes importantes. Il permit essentiellement à quelques universités de se doter de machines dédiées à la programmation dans le langage Pascal, à plus faible coût que l’achat de stations de travail alors beaucoup plus chères et dont l’éventail des usages possibles n’était pas utile à l’usage auquel elles étaient dédiées. En revanche, CP/M-86 et PC-DOS étaient en concurrence directe. Or, comme déjà indiqué, les deux systèmes étaient compatibles entre eux, de sorte qu’opter pour l’un ou l’autre était assez indifférent. Or, CP/M-86 était vendu 240 $, tandis que PC-DOS était vendu 40 $ – dans ses mémoires, Gary Kildall reproche à IBM d’avoir artificiellement augmenté le prix de CP/M-868Kildall, Gary (1994). Computer Connections, édition à compte d’auteur. Disponible en ligne.. Par ailleurs, CP/M-86 n’a été disponible pour l’IBM PC 5150 que trois mois après sa sortie, car Digital Research n’avait pas pu travailler sur la machine pendant sa conception. Aucune surprise quant au fait que PC-DOS s’imposa une fois l’IBM PC 5150 mis en vente, en 1981.

La guerre des clones

Grâce à un achat bien réalisé et aux négociations entre Digital Research et IBM, Microsoft s’est donc trouvé en possession d’un système d’exploitation, PC-DOS, qu’il pouvait vendre à qui le désirait, sans être contraint par IBM. En revanche, ce système était dédié à l’IBM PC 5150, donc si Microsoft était en théorie indépendant d’IBM, dans les faits la situation était identique à celle d’un prestataire qui aurait fourni un système d’exploitation à IBM. En tout cas, tant qu’il n’y aurait pas de machine compatible avec l’IBM PC 5150.

Les ingénieurs ayant conçu l’IBM PC 5150 avaient réalisé un bon travail pour proposer une machine de bureau adaptée aux petites entreprises, afin de réaliser leur comptabilité, leurs travaux bureautiques et une gestion de base de données minimaliste, mais bien suffisante pour les petites structures. De ce point de vue, si, bien entendu, il n’égalait pas la puissance de calcul des serveurs de l’époque, il offrait une puissance supérieure à la moyenne des machines de bureau alors commercialisée. Également, en accord avec l’inspiration de l’Apple ][, les ingénieurs d’IBM avaient doté le PC 5150 de capacités d’extensions importantes. Le budget et le temps réduits qui avaient été alloués au projet n’ont en définitive pas impacté la qualité de la machine. Le véritable impact c’est que, à l’exclusion d’un composant central, le BIOS, tous les composants constitutifs de l’IBM PC 5150 étaient des composants standards, contrairement aux autres microordinateurs de l’époque, qui incluaient de nombreux composants propriétaires. Cette caractéristique va s’avérer cruciale pour la suite de l’histoire.

La machine était bonne et la réputation d’IBM n’était plus à faire, de sorte que l’IBM PC 5150 fut un succès commercial. Même plus que ça : il ressort que les ventes ont dépassé les prévisions d’IBM de l’ordre de 800 %9Voir par exemple : Burton, Kathleen (1983). Anatomy of a colossus, part III, PC Mag, vol. 1, n° 10, pp. 467 – 478. Disponible en ligne.. De nombreux utilisateurs s’équipèrent de cette machine, ce qui attira bien entendu quelques convoitises.

Comme nous l’avons vu, l’IBM PC 5150 contenait essentiellement des composants standards, de sorte que n’importe qui pouvait construire une machine compatible. À l’exclusion donc du BIOS, qui lui était soumis à la propriété intellectuelle d’IBM. Ce dernier n’autorisant pas la duplication du BIOS, réaliser des machines clones de l’IBM PC 5150 semblait impossible.

Cependant, la loi américaine, en tout cas à l’époque, permettait à un technicien n’ayant pas participé au développement du matériel d’en réaliser une étude complète afin de documenter son fonctionnement. Toutefois, quiconque ayant réalisé un tel travail se voit interdit par la loi de réaliser un clone du composant analysé.

En revanche, un autre individu disposant des compétences nécessaires pour réaliser un clone et qui n’aurait pas travaillé sur l’élaboration du matériel était autorisé à suivre une description technique pour réaliser un clone de ce matériel. En conséquence, en payant un consultant n’ayant pas participé à la conception de l’IBM PC 5150 pour analyser le BIOS et en engageant des ingénieurs qui n’ont pas non plus travaillé à l’élaboration de la machine d’IBM, il était possible de produire tout à fait légalement des clones. Plusieurs fabricants vont s’engager dans cette brèche, conduisant à la multiplication des ordinateurs compatibles IBM PC.

Or, justement, Microsoft disposait du système d’exploitation de l’IBM PC, que les négociations entre IBM et Digital Research lui avait autorisé à commercialiser indépendamment du microordinateur d’IBM. Renommant le système MS-DOS, Microsoft ne va pas se faire prier pour distribuer ce système pour les clones de la machine d’IBM. Ainsi, Microsoft s’est-il trouvé à la tête d’un marché plus grand que prévu.

Toutefois, il n’y avait à ce moment-là pas encore de quoi qualifier ce contrat avec IBM de contrat du siècle.

L’émergence d’un standard de fait

Comme nous l’avons vu, l’IBM PC était bien conçu pour réaliser les tâches que, au début des années 1980, les petites entreprises commençaient à informatiser : la comptabilité et la gestion des stocks. Il proposait également des systèmes de traitement de texte, tout ce dont pouvait avoir besoin un professionnel n’appartenant pas à un grand groupe. En revanche, il n’était pas adapté aux usages principaux de l’informatique domestique alors naissante, à savoir les loisirs numériques. Ses capacités graphiques et sonores, sans être absentes, étaient en retrait par rapport aux ordinateurs 8 bits, tel le Commodore 64 sortis à peu près au même moment que l’IBM PC 5150, plus encore en comparaison des machines domestiques 16 bits sortie au milieu des années 1980.

La marque Tandy, avec la gamme d’ordinateurs Tandy 1000 initiée en 1984, avait proposé une machine offrant la puissance de calcul de l’IBM PC 5150, une compatibilité avec ce dernier, tout en proposant des possibilités graphiques et sonores au moins équivalentes aux autres machines domestiques. IBM avait déjà tenté d’introduire l’IBM PC Junior, au concept équivalent au Tandy 1000, mais à la compatibilité étonnamment un peu moins bonne avec l’IBM PC 5150.

Toujours est-il qu’on en est arrivé à une situation où de nombreux clones de l’IBM PC ont été mis en vente. Ceci a permis de créer un marché suffisamment étendu pour qu’il soit rentable pour un fabricant électronique de proposer des cartes d’extensions pour ces machines, lesquelles cartes d’extensions permettaient de doter les machines compatibles IBM PC des capacités nécessaires à telle ou telle application, par exemple le graphisme ou la musique. Ainsi, l’IBM PC est-il devenu une base à laquelle on pouvait adjoindre les composants nécessaires aux applications que l’utilisateur souhaitait réaliser. Cette polyvalence de la machine va favoriser sa diffusion.

Mutations dans l’informatique domestique

En 1984, Apple sort le premier Macintosh, machine au tarif plutôt élevé au regard des autres ordinateurs domestiques de l’époque, mais tout de même accessible au public domestique. Cet ordinateur offrait une interface graphique rendant l’utilisation bien plus aisée que pour les autres ordinateurs visant le même public, sur lesquels l’utilisation se faisait essentiellement par le biais de commandes entrées par l’utilisateur. Le concept d’interface graphique était en réalité en conception dans les laboratoires de recherches informatiques dès la fin des années 195010Le pionnier des interfaces graphiques est Douglas Carl Engelbart, qui a travaillé sur ce sujet dès la fin des années 1950 au Stanford Research Institute. et de premiers systèmes dédiés aux professionnels dotés de telles interfaces, notamment le Xerox Star (commercialisé en 1981), avaient été commercialisés à partir de la toute fin des années 1970 par Xerox. Cependant, c’est bien Apple qui proposa, avec le Macinstosh, le premier ordinateur doté d’une interface graphique à un tarif à peu près abordable pour un particulier.

Suite à la sortie du Macintosh, tant Digital Research que Microsoft développèrent rapidement leur propre système d’interface graphique. Si Microsoft Windows n’a guère convaincu, Digital Research a proposé le système GEM (pour Graphical Environement Manager), qui lui était tout à fait compétitif en regard de ce que proposait le Macintosh. Pour tout dire, GEM a même introduit certaines pratiques ergonomiques encore en usage de nos jours et son interface de programmation était bien plus rigoureuse que celle proposée par le Macintosh. Ainsi, la polyvalence de l’IBM PC lui permettait-elle d’offrir des possibilités multiples et, désormais, une interface utilisateur très accessible, en tout cas tout autant que ce que proposait la concurrence.

Voyant bien le danger que représentait la possibilité d’avoir la même accessibilité sur les ordinateurs compatibles IBM PC que sous Macintosh, Apple a alors attaqué Digital Research pour plagiat. Lorsqu’on se rappelle que Microsoft a pu s’imposer sur compatible IBM PC en proposant un système d’exploitation reproduisant le fonctionnement de celui proposé par Digital Research et sachant qu’Apple a lancé une action à propos d’une technologie qu’il avait reprise d’un laboratoire de Xerox, c’est tout de même tragiquement ironique.

Apple n’ayant pas inventé le principe d’interface graphique, il ne parvint pas à obtenir le retrait du marché de GEM. En revanche, il obtint la suppression d’éléments secondaires, mettant tout de même à mal la cohérence de l’expérience utilisateur, telle que la suppression de l’icône poubelle. Par ailleurs, ce procès a retardé la diffusion de GEM, tandis que de plus en plus de programmes utilitaires se diffusaient pour MS-DOS, qui ne tiraient donc pas parti de GEM, rendant ce dernier bien moins attractif. En conséquence, GEM fut un échec.

Ainsi, les compatibles IBM PC ont ils tiré une réputation de machines austères, dédiées à des usages techniques.

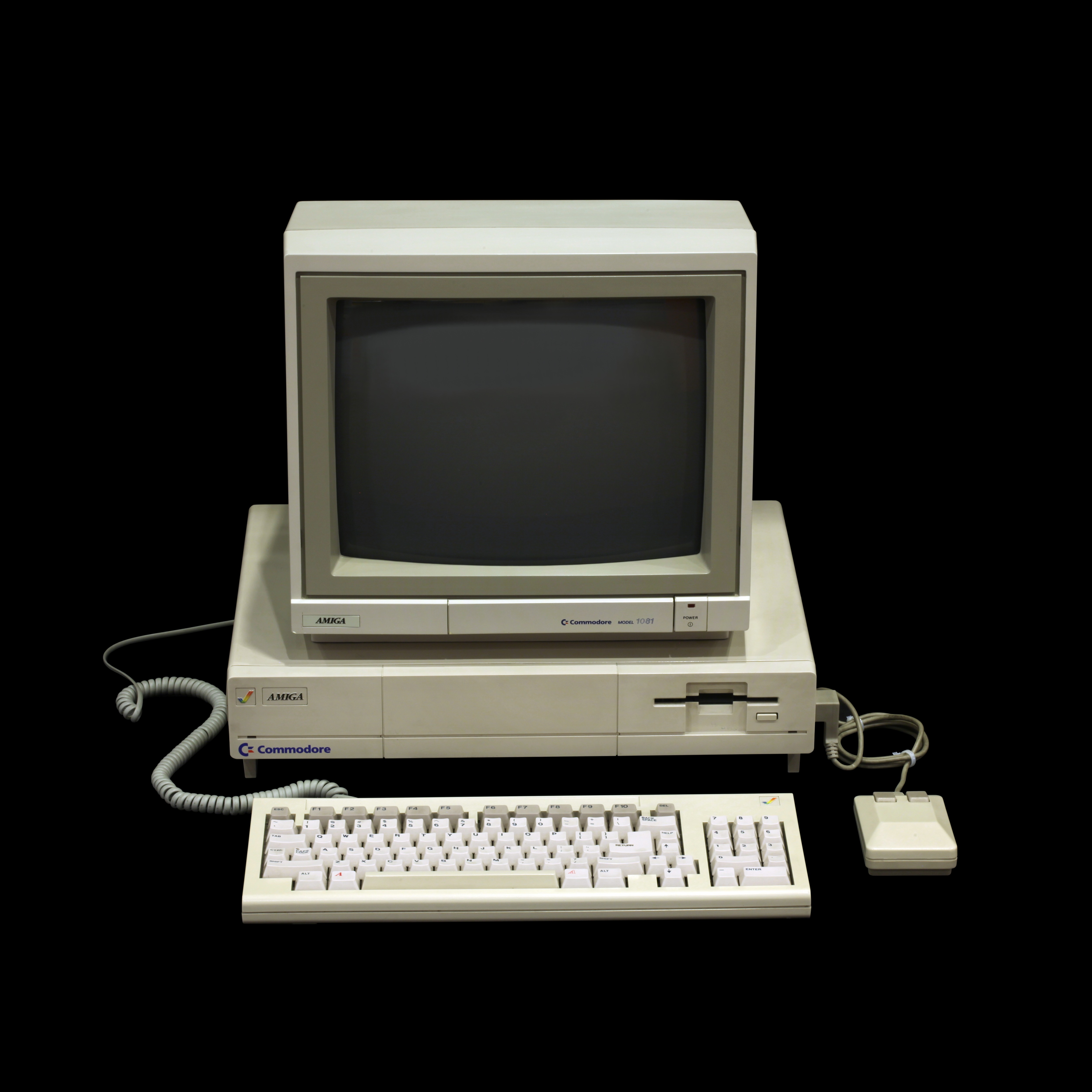

Ceci d’autant plus qu’en 1985 Atari Corporation sortit l’ordinateur domestique Atari ST, puis Commodore International l’Amiga. Si l’Atari ST a été commercialisé avant l’Amiga, il a en réalité été conçu pour concurrencer l’Amiga. En effet, la conception de l’Amiga avait pris du temps, mais il avait fait parler de lui avant même sa mise en production. Atari avait tenté de le racheter, mais Commodore International l’avait coiffé au poteau. Pour ne pas rester démuni face à la concurrence, Atari a alors conçu l’Atari ST, une machine moins innovante, mais qui tout de même pouvait tenir la comparaison face à l’Amiga, d’autant qu’elle était commercialisée pour bien moins cher. Par ailleurs, puisque nous avons parlé de GEM, signalons que ce fut le système choisi par Atari, d’autant que le procès avec Apple ne concernait que les ordinateurs compatibles IBM PC. C’est la commercialisation de l’Amiga et de l’Atari ST qui a réellement lancé l’ère des ordinateurs domestiques 16 bits, le Macintosh étant, lui aussi, un ordinateur 16 bits. Ces trois ordinateurs disposaient d’une interface graphique.

Cette situation a provoqué, aux États-Unis, un morcellement de l’informatique domestique et dédiée aux professionnels indépendants en quatre parties : les ordinateurs compatibles IBM PC étaient des machines dédiées à la bureautique simple, la programmation, l’usage de tableurs et de la gestion de bases de données simples. Le Macintosh était une machine orientée vers des utilisateurs plus fortunés, principalement pour réaliser de la bureautique, du graphisme et de la publication assistée par ordinateur. L’Amiga était la machine privilégiée des graphistes et pour l’audiovisuel, ainsi qu’une plateforme de jeux particulièrement convaincante. Par la présence en standard de prise MIDI et la très grande stabilité de son système d’exploitation, l’Atari ST était l’ordinateur privilégié pour la musique assistée par ordinateur et du fait de son processeur plus puissant que celui du Macintosh et la disponibilité d’un écran plus grand, l’Atari ST était en concurrence avec le Macintosh dans la publication assistée par ordinateur. C’était également une plateforme de jeux convaincante, même si ses capacités dans ce domaine étaient un peu en retrait par rapport à l’Amiga.

En Europe, des constructeurs proposèrent bien des machines alternatives, mais le marché était trop morcelé entre les différents pays, ce qui rendait la concurrence des constructeurs américains bien trop écrasante, ces derniers tirants une grande puissance financière de leur marché intérieur.

Le Macintosh, l’Amiga et l’Atari ST connurent des volumes de ventes semblables à ceux que connaissait le secteur avant la sortie de l’IBM PC, le Macintosh s’étant mieux vendu, l’Atari ST s’étant moins bien vendu. En revanche, les ordinateurs compatibles IBM PC avaient ouvert un marché bien plus grand, créant un parc d’un bon ordre de grandeur plus grand que celui des autres machines. Ainsi, il était rentable de vendre des logiciels à des prix abordables uniquement destinés à l’IBM PC, ce qui était beaucoup plus délicat à faire pour les autres ordinateurs. Ceci engendra une dynamique dans laquelle l’offre pour les ordinateurs compatibles IBM PC entrainait une augmentation des utilisateurs de ces machines, ce qui réduisait la quantité d’utilisateurs des autres machines. Le succès des compatibles IBM PC entrainait l’échec des autres microordinateurs domestiques.

En 1990, en publiant Microsoft Windows 3.0, Microsoft est enfin parvenu à proposer une interface graphique vraiment convaincante. Apple va alors intenter un procès à Microsoft, lui reprochant d’avoir copié son expérience utilisateur. Sans doute pour se protéger, Xerox va à son tour poursuivre Apple, pour les mêmes raisons. Aucun de ces procès n’aboutit11Une page en anglais de Wikipédia rassemble les éléments de ces procès..

Par ailleurs, les ordinateurs compatibles IBM PC ont été capables de suivre l’évolution des processeurs x86 d’Intel, passant au 80286, puis au 80386, basculant dans le monde 32 bits. À ce stade, les ordinateurs compatibles IBM PC présentaient des options crédibles dans tous les domaines couverts par les machines concurrentes. Par ailleurs, c’est à peu près vers cette époque que sont apparus sur le marché des ordinateurs produits par des assembleurs asiatiques aux coûts plus réduits, rendant ces machines d’autant plus abordables. Ainsi, dès le début des années 1990, il était clair que l’informatique domestique serait dominée par les ordinateurs compatibles IBM PC et donc que Microsoft aurait un rôle central.

Cependant, si le contrat avec IBM s’était d’ores et déjà avéré très rentable pour Microsoft, à ce stade, on ne le qualifiait pas encore de contrat du siècle.

Toi aussi, mon fils !

Comme vous avez pu le constater, une part importante du succès de l’IBM PC venait en fait de l’existence de clones. En conséquence, IBM perdait la main sur la plateforme qu’il avait lui-même créée. À plusieurs reprises, il tenta de reprendre la main face à ses concurrents. L’IBM PC Junior, dont il a été question plus haut, était la première de ces tentatives. IBM a également proposé plusieurs évolutions de l’IBM PC, par exemple l’IBM PS/2 (pour Personal System 2), qui proposait un processeur plus puissant et des ports de connexion propriétaires (mais bientôt copiés). Aucune de ces tentatives ne changea réellement la donne.

Toutefois, il était assez rapidement apparu que le système PC-DOS nécessitait une évolution importante. Cette fois-ci, IBM décida de profiter de ses compétences internes, quoique toujours en partenariat avec Microsoft. Les deux entreprises travaillèrent donc sur un projet commun de nouveau système d’exploitation, nommé OS/2 (pour Operating System 2), dont la première version a été publiée en 1987. Dans un premier temps, il n’était pourvu que d’une interface en mode texte, mais il fut doté d’une interface graphique dans la version suivante, publiée en 1988. Dès le départ, OS/2 offrait une compatibilité avec PC-DOS, c’est-à-dire qu’un logiciel développé sous PC-DOS pouvait fonctionner sans même une recompilation sur OS/2.

OS/2 était un projet ambitieux et, s’il ne négligeait pas le marché des particuliers, son orientation était plutôt les usages professionnels. Cependant, il existait déjà un standard de fait dans l’industrie : le système Unix. Ce système avait d’abord été popularisé dans les universités, puis, dans les années 1980, dans les entreprises et industries. À cette époque, ce système fonctionnait encore sur des machines plus puissantes que les compatibles IBM PC. D’ailleurs, si les systèmes Unix originaux ne sont, pour la plupart, plus en service, ce standard a été formalisé par la norme POSIX et est toujours en usage de nos jours. Les applications sur les systèmes de grande échelle se basent donc sur ce standard. Or, OS/2 n’était pas, en tout cas pas complètement, compatible POSIX. Pour perdurer sur le marché professionnel, OS/2 devait en conséquence créer un nouvel écosystème, alors qu’il en existait un déjà bien en place.

À ce stade, l’analyse des exécutifs de Microsoft était que, si le partenariat avec IBM lui avait permis de se développer, désormais il s’agissait d’un frein à sa croissance. Ils décidèrent alors de mettre fin à ce partenariat et de lancer un projet concurrent. Il a déjà été question dans cet article de Microsoft Windows, qui était à cette époque une surcouche de MS-DOS, proposant une interface graphique. Utilisant la même interface graphique, Microsoft proposa un tout nouveau système, Microsoft Windows NT (NT signifiant New Technology). Si l’interface graphique était la même que celle de Microsoft Windows, en interne le système différait largement de MS-DOS, de sorte qu’il ne proposait pas une très grande compatibilité avec ce dernier. Ce système était, lui aussi, destiné aux professionnels. Les deux anciens partenaires, IBM et Microsoft, se retrouvaient donc en concurrence sur exactement le même segment, avec un succès équivalent. Au demeurant, les clients optant pour OS/2 avaient tendance à s’équiper de matériel IBM, tandis que Microsoft Windows NT tendait plutôt à équiper des clones – cela dit, encore une fois, il s’agissait là surtout d’une tendance générale.

En 1995, Microsoft sortit le système d’exploitation Microsoft Windows 95. Celui-ci était plutôt destiné aux particuliers. Il s’agissait d’un système en grande partie nouveau, mais il offrait tout de même une grande compatibilité avec MS-DOS. Ainsi, la migration de l’un à l’autre était-elle simplifiée. Aidé par une campagne de publicité agressive et de pratiques anti-concurrentielles12Un article de Wikipédia fait un résumé des pratiques controversées de Microsoft et donne de nombreuses références étayant les faits., ce système d’exploitation parvint à s’imposer rapidement. Ainsi, Microsoft affermit sa position d’acteur incontournable de l’informatique domestique. En revanche, dans l’industrie, POSIX restait la norme. Microsoft avait réussi à bien mener sa barque. Mais nous n’en sommes toujours pas au stade qui a permis de dire que Microsoft avait signé le contrat du siècle.

Un Unix pour les gouverner tous

En 1969, Kenneth Lane Thomson et Dennis MacAlistair Ritchie, chercheurs au laboratoire Bell, se trouvaient un peu désœuvrés après que leur laboratoire eut abandonné sa participation à l’élaboration du système Multics, un projet de système d’exploitation particulièrement ambitieux, mais qui n’a jamais obtenu le succès escompté. Pour occuper son temps libre, Kenneth Thomson se décida à porter un jeu qu’il avait programmé sur un ordinateur PDP-7. Cependant, cet ordinateur ne disposait pas d’un système d’exploitation qui fût adapté à ses besoins. Avec l’aide de Dennis Ritchie, il conçut un système à partir de zéro. Comme, à la différence du projet Multics, ce système réalisait toutes ses tâches de manière unifiée, là où Multics proposait de nombreux paradigmes différents, le système fut appelé « Unics », bientôt écrit avec un « x » : Unix.

En vérité, ce système était bien plus que le simple support pour un jeu : ses concepteurs ont profité de toute leur expérience dans la conception de systèmes d’exploitation, notamment celle obtenue en travaillant sur le projet Multics, pour réaliser un système d’exploitation complet et tout à fait efficace. En particulier, il s’agissait d’un système d’exploitation parfaitement fonctionnel qui était à la fois multitâches et multi-utilisateurs. Multitâche indique que le système permet de faire fonctionner plusieurs programmes en même temps. Multi-utilisateurs indique que plusieurs personnes peuvent avoir accès au même ordinateur avec un espace de travail individualisé. En proposant ainsi une interface unifiée, en proposant la possibilité de réaliser du travail multitâche et de connecter plusieurs utilisateurs différents, le tout dans un système d’exploitation efficace, Kenneth Thomson et Denis Ritchie ont réussi à proposer ce que plusieurs projets de système d’exploitation n’avaient pas réussi, à commencer par le projet Multics. Par ailleurs, l’interface unifiée d’Unix simplifiait grandement l’utilisation d’un ordinateur. En conséquence, Unix a provoqué pas mal d’intérêt dans la communauté, alors certes restreinte, mais en pleine expansion, des concepteurs et des utilisateurs de systèmes informatiques. Rapidement, Unix a été porté sur de nombreuses machines, mettant en place au passage des méthodologies et des outils rendant ce portage d’autant plus simple.

Or, à l’époque, les lois contre les pratiques de monopoles interdisaient à Bell de réaliser une exploitation commerciale d’Unix. En conséquence, le système était distribué sous forme de code source pour un montant symbolique. Ceci facilita d’autant la prolifération du système, d’une part, mais aussi encouragea ses utilisateurs à proposer des évolutions et des améliorations du système. Ainsi, Unix put-il se constituer une base très solide d’utilisateurs, mais aussi thésauriser sur ses qualités de départs et évoluer à mesure que l’informatique évoluait elle aussi. Très rapidement, ce système est donc devenu une référence.

Dans le courant des années 1980, une évolution dans le statut de Bell a permis la diffusion d’Unix de manière plus commerciale. Par ailleurs, les progrès dans les microprocesseurs permettaient de réaliser des microordinateurs tout à fait performants. On vit ainsi apparaître des ordinateurs de bureau destinés à des usages professionnels : les stations de travail, qui généralement étaient proposées avec un système d’exploitation Unix ou un dérivé. Ces microordinateurs étaient trop chers pour pouvoir être achetés par des particuliers, mais connurent un vrai succès dans les industries et au sein des universités. Unix devenait donc le standard de fait dans ces milieux.

De base, Unix permettait une grande portabilité des programmes fonctionnant sur ce système. En effet, quelque soit l’architecture matérielle sur lequel tourne le système, il offre une interface de programmation unifiée, de sorte qu’une simple recompilation permet de faire fonctionner un programme donné sur une nouvelle architecture.

Cependant, dans les années 1980, les constructeurs d’ordinateurs pourvus de systèmes dérivés d’Unix proposaient des évolutions qui leur étaient propres, mettant à mal le modèle de portabilité d’Unix. Pour pallier cet état de fait, les principaux fournisseurs de systèmes dérivés d’Unix se rassemblèrent pour établir une norme de système d’exploitation, la Portable System Interface, appelée « POSIX » (le « x » étant une allusion à Unix). Ainsi, tout programme se basant sur cette norme peut-il être aisément compilé sur n’importe quel système implémentant cette norme. Unix était donc prêt pour dominer le Monde de l’informatique !

La guerre des Unices

Comme indiqué plus haut, à la fin des années 1980, il apparaissait assez clairement que l’industrie nécessitait une norme pour ses applications informatiques. La norme POSIX reposait sur un écosystème qui avait émergé près de vingt ans auparavant, qui avait montré sa formidable capacité de mise à jour et d’adaptation aux évolutions du domaine : il apparaissait clairement que POSIX était le candidat idéal. Et le marché s’annonçait tout à fait conséquent, à savoir l’essentiel du marché industriel, universitaire et des grands groupes.

Bien évidemment, tous les constructeurs souhaitaient profiter de l’aubaine. Et donc attirer les utilisateurs avec leurs fonctionnalités spécifiques. Si la base de l’interface de programmation pour l’accès aux ressources de base du système était l’objet d’une norme, ça n’était pas le cas pour les interfaces graphiques. En effet, le monde Unix s’était doté de systèmes d’interfaces graphiques dès le début des années 80, sous l’influence du Star de Xerox et avant l’introduction du Macintosh par Apple. Cependant, à la fin des années 1980, aucun standard ne s’était alors imposé. Chaque fabricant tentait donc de proposer son propre système, dans l’espoir d’augmenter ses parts de marché : on se retrouvait avec exactement le problème que visait à résoudre la norme POSIX, à savoir un affaiblissement du modèle de portabilité Unix.

Après plusieurs péripéties que je ne détaille pas pour cet article – cela nous amènerait trop loin de notre sujet, à savoir comment Microsoft est arrivé à la situation permettant de dire qu’il avait signé le contrat du siècle, – la formation de l’Open Group, réunissant les acteurs majeurs du monde POSIX (dont IBM), permit au secteur de s’entendre sur un standard également pour la réalisation d’interfaces graphiques. Il existait enfin une norme couvrant l’essentiel des besoins pour l’utilisation des ressources matérielles nécessaires au fonctionnement d’un programme. Toutefois, cette bataille des Unices avait mis à mal l’image d’interopérabilité des systèmes POSIX, retardant l’accession à l’hégémonie auquel cet écosystème semblait promis.

Cependant, un constructeur avait tout de même réussi à s’imposer très fortement : Sun Microsystems proposait des systèmes très utilisés dans l’infrastructure d’Internet et pour la gestion des réseaux d’entreprises. L’expansion d’Internet lui permettait d’avoir un marché en permanente extension. En définitive, il apparaissait que ce n’était plus qu’une question de temps avant que les systèmes POSIX couvrent l’essentiel des systèmes installés.

L’explosion de la bulle Internet

Toutefois, au début des années 2000, ce qui en définitive avait d’abord été une bulle spéculative explosa : de nombreuses petites structures qui avaient profité de la libéralisation d’Internet pour se lancer durent cesser leurs activités faute d’avoir trouvé un modèle rentable. Ceci impacta les acteurs des systèmes POSIX, au cœur de l’économie numérique. En particulier Sun Microsystems, qui, si en elle-même représentait une structure tout à fait solide, avait parmi ses clients de nombreux petits acteurs qui ne supportèrent pas la fin de cette bulle. La perte brutale de nombreux clients fragilisa fortement Sun Microsystems : l’acteur majeur du monde POSIX des années 1990 fut contraint de considérablement réduire la voilure dans le courant des années 2000.

Au demeurant, quel rapport avec Microsoft et son fameux contrat du siècle ? À ce stade, pas grand-chose. Pour tout dire, Microsoft a même un peu traîné des pieds en ce qui concerne la connectivité à Internet, même s’il a, au tournant des années 2000, usé de pratiques anti-concurrentielles pour imposer ses solutions de connexion à Internet sur les alternatives proposées, pourtant souvent plus abouties d’un point de vue fonctionnel.

À ce stade, la plateforme PC restait une plateforme 32 bits, quand les applications industrielles et de calculs les plus exigeantes tournaient sur des stations de travail POSIX 64 bits : au début des années 2000, la séparation entre l’informatique personnelle et l’informatique d’applications exigeantes restait encore nette.

AMD révolutionne Intel

S’il était clair qu’il n’était pas possible de conserver indéfiniment le système d’exploitation MS-DOS, il semblait clair également que la plateforme x86 d’Intel ne pouvait pas perdurer. L’architecture avait réussi le passage du 16 au 32 bits et avait su se renouveler, mais ça n’en demeurait pas moins une architecture initialement conçue à la fin des années 1970, qui faisait avec les contraintes techniques de cette époque. En particulier, entre la fin des années 1980 et les années 1990, les stations de travail POSIX avaient basculé vers une nouvelle forme de processeurs : les processeurs RISC13Devant la faible taille des mots dans les processeurs 8 bits et précédant, pour pouvoir augmenter le nombre d’instructions, les concepteurs de processeurs réalisaient des architectures utilisant des instructions pouvant être codées sur plusieurs mots. La taille des mots dans les processeurs 32 et 64 bits permet d’avoir un jeu d’instruction varié en utilisant des instructions de tailles constantes : c’est le principe des architectures RISC. La constance dans la taille des instructions permet d’appliquer de nombreuses optimisations dans l’exécution des instructions du processeur.. Ces architectures présentaient des performances significativement supérieures aux architectures précédentes. Assez rapidement, pour les analystes, il ressortait que la logique pour les ordinateurs était de migrer vers les architectures RISC.

Intel lui-même avait produit des processeurs RISC, mais ces derniers n’ont pas obtenu un grand succès, en tout cas bien plus faible que l’architecture x86 – cette dernière était portée par le succès des ordinateurs compatibles IBM PC. Au contraire, IBM, en partenariat avec Motorola, proposait l’architecture RISC POWER dont la déclinaison pour ordinateur de bureau, les PowerPC, a rapidement convaincu par ses qualités. Microsoft proposait bien une version de Windows NT pour PowerPC, mais ce dernier n’a jamais réussi à s’imposer : il ressort que l’argument principal en faveur de Microsoft Windows est la compatibilité binaire – c’est-à-dire qu’à la différence du modèle de portabilité Unix, il n’est pas besoin de recompiler les programmes pour les faire fonctionner sur une nouvelle machine. Si cela constitue une simplification immédiate pour la diffusion de programme pour les éditeurs de logiciels, ça conduit également à bloquer la possibilité de changer d’architecture. En tout cas, sur les plateformes qui n’étaient pas basées sur l’architecture x86, jamais Microsoft Windows n’est parvenu à obtenir une part de marché significative.

Vers le milieu des années 1990, en dépit du succès de Microsoft Windows 95, il semblait donc assez clair qu’on se trouvait à l’aube d’un changement d’architecture et Unix semblait bien plus à même d’accompagner ce changement. Au demeurant, avec l’introduction du Pentium Pro, Intel est parvenu à appliquer sur l’architecture x86 les optimisations propres aux processeurs RISC. Dès lors, les processeurs Pentium d’Intel sont devenus compétitifs en regard des processeurs PowerPC d’IBM et Motorola : pour la plupart des applications concrètes, il n’y avait pas de différence déterminante entre les deux architectures. En conséquence, le modèle de compatibilité de Microsoft Windows poussait à conserver toujours la même architecture : pour la génération des processeurs 32 bits, en tout cas, l’avenir des processeurs x86 était assuré et Microsoft Windows a pu établir une base solide d’utilisateurs.

Cependant, dès la deuxième partie des années 1990, les ordinateurs à destination des usages industriels ont basculé vers des processeurs 64 bits. Là encore, il ne s’agissait pas de l’architecture x86 et les systèmes fonctionnant sur ces ordinateurs étaient des systèmes POSIX. La démarcation restait claire et, en dépit de la capacité dont Intel avait fait preuve pour faire évoluer son architecture, il apparaissait clair même pour lui qu’il lui fallait proposer une nouvelle architecture. En conséquence, Intel a lancé un projet visant à produire une architecture 64 bits particulièrement ambitieuse, conduisant à la série des processeurs Itanium, mais qui, malheureusement, ne parvint jamais à répondre à ses promesses.

Au demeurant, Intel restait solide d’une part grâce au parc d’ordinateurs compatibles IBM PC installés, d’autre part parce qu’il produisait également des processeurs basés sur l’architecture x86, mais dédiés aux serveurs. Ces derniers permettaient aux petites structures de mettre en place leurs propres serveurs à bas coût, ou bien en utilisant une version de Microsoft Windows dédiée à ce genre de serveurs, ou bien en utilisant un système d’exploitation libre compatible POSIX tel que GNU/Linux.

En revanche, l’architecture POWER possédait une version 64 bits dès le milieu des années 1990, de sorte que les PowerPC purent assez aisément évoluer, eux aussi, vers une architecture 64 bits. Intel, de son côté, rechignait à produire une version 64 bits de l’architecture x86, probablement principalement pour ne pas se faire soi-même de la concurrence envers ses processeurs Itanium.

Cependant, Intel n’était pas le seul constructeur de processeurs x86. En effet, dès 1976, Intel avait passé un accord dit de cross-license avec le constructeur AMD14C’est notamment confirmé par Intel.. Ceci permettait à AMD de produire des processeurs x86 si, par exemple, la demande était trop forte pour les capacités de production d’Intel. Ainsi, Intel fournissait les masques permettant la production de processeurs 8086/8088 à AMD, qui pouvait produire des processeurs répondant à cette architecture : les processeurs étaient identiques, dans la mesure où la conception était intégralement réalisée par Intel quel que soit celui qui produisait les processeurs.

Toutefois, en 1985, à la faveur d’évènements un peu trop longs à résumer ici, Intel s’est imposé comme la seule source de production pour les processeurs 80386 et supérieurs. Pour survivre, AMD a alors dû investir dans la recherche et le développement sur l’architecture x86. Dans les dix années qui suivirent, AMD ne parvint pas à convaincre. Il a finalement acheté en 1996 la société NexGen, spécialisée dans la conception de puces informatiques. En se basant sur les compétences de NexGen, en 2003, AMD va enfin proposer une évolution de l’architecture x86 qui va le démarquer, en particulier en faisant basculer cette architecture vers une architecture 64 bits. Ainsi, il proposait non seulement une architecture compatible avec les processeurs des ordinateurs compatibles IBM PC, mais aussi compétitive en regard de ce qu’on trouvait à l’époque sur les stations de travail.

Les systèmes libres comme GNU/Linux supportaient déjà d’autres architectures 64 bits, disposaient d’une grande réactivité de développement et donc tirèrent rapidement parti de la nouvelle architecture. La première conséquence fut donc de rendre cette architecture très compétitive sur le marché des stations de travail et des serveurs, ce qui notamment entraîna une réduction des coûts. Microsoft, pour sa part, publia des versions de Microsoft Windows adaptée à cette architecture environ un an après qu’elle a été rendue disponible. Ainsi, Microsoft proposait un système globalement compétitif avec celui des stations de travail, tout en offrant la compatibilité binaire avec les programmes développés pour les versions antérieures de ce système et pour les architectures précédentes. De plus, son offre pour serveur devenait, elle aussi, compétitive avec l’ensemble de ce marché.

Dans un premier temps, Intel ne voulut pas suivre cette évolution. Cependant, au vu de l’évolution du marché, il dut réagir et proposa bientôt, lui aussi, une version 64 bits de l’architecture x86, entérinant l’échec de l’architecture Itanium.

Ce n’est donc qu’à ce stade que tous les éléments étaient en place pour permettre à Microsoft de devenir l’acteur majeur dans une large partie de l’informatique en général qu’il est aujourd’hui. Ce n’est qu’à ce moment-là qu’on peut véritablement dire que le contrat qu’il avait signé avec IBM s’était révélé être « le contrat du siècle ».

Conclusion provisoire

La légende de Microsoft et plus particulièrement de Bill Gates raconte souvent que ce dernier aurait réussi à arnaquer IBM lors de la conception de l’IBM PC 5150. Cependant, à cette époque, Microsoft était une toute petite structure qui n’était pas le moins du monde en mesure d’imposer quoi que ce soit à IBM. Plus encore, c’est bien parce que Microsoft ne pouvait qu’accepter les conditions revendiquées par IBM sans négociation qu’il a obtenu le contrat plutôt que Digital Research.

Les raisons qui ont fait que ce partenariat à l’origine léonin est devenu pour Microsoft le contrat du siècle tient aux circonstances, à la chance, à de l’opportunisme de la part des dirigeants de Microsoft, ainsi qu’à des pratiques anti-concurrentielles. Une histoire certes moins romantique, surtout moins flatteuse pour les dirigeants de Microsoft, mais bien plus crédible.

Par ailleurs, il faut aussi se méfier de notre tendance à la téléologie, c’est-à-dire à notre tendance à déjà voir la fin dans les prémisses des évènements. On a tendance à s’imaginer que Microsoft a réalisé une stratégie implacable, qui devait inéluctablement faire de lui le géant incontesté de l’informatique. Cependant, en vérité, bien des choses auraient pu tourner tout à fait différemment et les évènements nous auraient semblé tout autant implacables.

Dès les années 1950 et jusqu’au début des années 1980, IBM était le géant hégémonique qui dominait le monde informatique et il n’apparaissait pas que cet état de fait devait changer dans un futur proche. Dans le courant des années 1990, de nombreux acteurs du monde Unix avaient peur que Sun ne devienne un ogre qui dévore tout le marché. Si ces analyses étaient tout à fait pertinentes, elles ne s’en sont pas moins révélées fausses. Aujourd’hui, Microsoft est un géant, mais il n’était pas destiné à le devenir et on ne peut pas considérer la situation actuelle comme immuable.

Il y a encore quelques années, la situation semblait figée. L’architecture ARM dominait le monde de l’embarqué en utilisant comme système d’exploitation Android, QNX ou bien des systèmes dédiés basés sur Linux. Les ordinateurs de bureau, y compris les Macintosh d’Apple, utilisaient tous l’architecture x86, avec une domination écrasante de Microsoft Windows dans le domaine, même si macOS disposait d’une base d’utilisateurs plus faible, mais solide et qu’une minuscule part des stations de travail faisait tourner GNU/Linux (ce constat provient d’un utilisateur exclusif de GNU/Linux). Dans le secteur des serveurs, là encore l’architecture x86 était hégémonique, tandis que le système d’exploitation majoritaire était GNU/Linux quand bien même Microsoft Windows restait un acteur important. Concernant les applications fortement demandeuses, tel que le calcul scientifique, là aussi l’architecture x86 était hégémonique, ainsi que le système GNU/Linux.

Cependant, aujourd’hui, il y a des indices forts indiquant que nous pourrions vivre un changement d’architecture à grande échelle : plusieurs facteurs y concourent. D’une part, l’architecture x86 ainsi que le système Microsoft Windows forment deux boîtes noires toutes les deux conçues aux États-Unis, ce qui pose d’importants problèmes de souverainetés. L’architecture ouverte RISC-V propose une solution plus collaborative, tandis que les logiciels libres forment déjà une offre fonctionnellement équivalente à l’écosystème Microsoft Windows, même s’ils impliquent d’importants changements dans les habitudes d’utilisation. Par ailleurs, le modèle de compatibilité binaire de Microsoft Windows a certes facilité la diffusion de logiciels propriétaires, mais constitue une forte entrave à l’innovation. Apple a d’ailleurs très récemment introduit ses propres processeurs dédiés aux machines de bureau, basés sur l’architecture ARM, un des signes les plus médiatisés indiquant la possibilité prochaine d’un changement d’architecture à grande échelle. De son côté, l’Union européenne a lancé des projets visant à produire des machines de calcul à hautes performances basées sur l’architecture RISC-V.

On aurait tort de penser que la position de Microsoft est inébranlable : les cas d’IBM et de Sun, évoqués dans cet article, mais aussi bien d’autres exemples dans différentes industries, montrent que les choses peuvent changer radicalement en peu de temps et force est de constater que tous les efforts de Microsoft pour s’imposer sur d’autres architectures que le x86 ont été un échec. À l’inverse, avant d’enterrer Microsoft et Intel, il est bon de se rappeler qu’il y a déjà eu plusieurs périodes pendant lesquelles il apparaissait clairement que cet écosystème était dépassé et pourtant ce dernier a su non seulement perdurer, mais plus encore devenir florissant.

La période actuelle est intéressante à observer, car ce qui semblait une situation figée depuis longtemps peut aujourd’hui se trouver en passe de changer du tout au tout. Ou bien les choses peuvent continuer comme avant. Nous ne devrions pas avoir besoin d’attendre trop longtemps pour le savoir.

Mais, en tout état de cause, il est clair qu’à la fin des années 1970 Microsoft n’était pas en mesure d’imposer quoi que ce soit à IBM. Lorsqu’on connaît la fin de l’histoire, on a tendance à voir cette fin dans les prémisses, mais le contrat du siècle n’a jamais existé : c’est l’évolution de la situation qui l’a produit.

Remerciements

Je remercie les membres de l’association MO5.com pour avoir relu cet article et plus particulièrement Christophe Menebœuf, qui a apporté plusieurs corrections et précisions, ainsi que Guillaume Verdin et Sseb22 pour leurs relectures orthographiques.

Notes

| ↑1 | Cringley, Robert X. (1996). Accidental empires: How the boys of Silicon Valley make their million, battle foreign competition, and still can’t get a date, édition mise à jour, HarperCollins. Disponible sur le site de l’auteur. |

|---|---|

| ↑2 | Cringley, Robert X. (1996). Triumph of the Nerds, Channel 4. Disponible en ligne en deux parties. Il y a également un site compagnon du reportage, qui fleure bon les années 1990 ! |

| ↑3 | Cheifet, Stewart (1995). « Gary Kildall Special », Computer Chronicles, PBS. L’épisode est disponible en ligne. |

| ↑4 | Maher, Jimmy (2012). The IBM PC, 4 parties, The Digital Antiquarian. Article publié en ligne. |

| ↑5 | Un compilateur est un programme permettant de transformer un code source en programme exécutable par la machine, c’est donc l’outil central et nécessaire à la création de logiciels. |

| ↑6 | Les dirigeants ne Microsoft ont déclaré, par exemple dans Revenge of the nerds, avoir adressé IBM à Digital Research, mais Gary Kildall aurait été plus intéressé par piloter son avion que de répondre à IBM. Cependant, cette version est démentie par les employés de Digital Research, par exemple dans l’épisode spécial des Computer Chronicles consacré à Gary Kildall, ainsi que par le travail du journaliste Andrew Orlowski, tant dans MS-DOS paternity suit settled (30 juillet 2007, The Register, disponible en ligne) que dans Bill Gates, Harry Evans and the smearing of a computer legend (7 août 2012, The Register, disponible en ligne). Par ailleurs, il est peu crédible que l’équipe de développement de l’IBM PC 5150 ait entendu parler de Microsoft, à l’époque une très petite structure, mais pas de Digital Research, qui était alors un acteur majeur du monde de la microinformatique. La version présentée ici est donc celle qui est la plus probable. |

| ↑7 | Voir la copie du contrat fourni comme élément de preuve dans l’un des procès à l’encontre de Microsoft, disponible en ligne. |

| ↑8 | Kildall, Gary (1994). Computer Connections, édition à compte d’auteur. Disponible en ligne. |

| ↑9 | Voir par exemple : Burton, Kathleen (1983). Anatomy of a colossus, part III, PC Mag, vol. 1, n° 10, pp. 467 – 478. Disponible en ligne. |

| ↑10 | Le pionnier des interfaces graphiques est Douglas Carl Engelbart, qui a travaillé sur ce sujet dès la fin des années 1950 au Stanford Research Institute. |

| ↑11 | Une page en anglais de Wikipédia rassemble les éléments de ces procès. |

| ↑12 | Un article de Wikipédia fait un résumé des pratiques controversées de Microsoft et donne de nombreuses références étayant les faits. |

| ↑13 | Devant la faible taille des mots dans les processeurs 8 bits et précédant, pour pouvoir augmenter le nombre d’instructions, les concepteurs de processeurs réalisaient des architectures utilisant des instructions pouvant être codées sur plusieurs mots. La taille des mots dans les processeurs 32 et 64 bits permet d’avoir un jeu d’instruction varié en utilisant des instructions de tailles constantes : c’est le principe des architectures RISC. La constance dans la taille des instructions permet d’appliquer de nombreuses optimisations dans l’exécution des instructions du processeur. |

| ↑14 | C’est notamment confirmé par Intel. |

Une réflexion sur « Comment Microsoft n’a pas négocié le contrat du siècle »